«Память — это сетевой процесс», — говорит профессор Калифорнийского университета в Санта-Барбаре Франческо Булло, объясняя, что ассоциативные воспоминания не хранятся в отдельных клетках мозга. — «Хранение и извлечение воспоминаний — это динамические процессы, которые происходят в целых сетях нейронов».

Перепрошивка памяти: новая модель памяти, которая работает как мозг

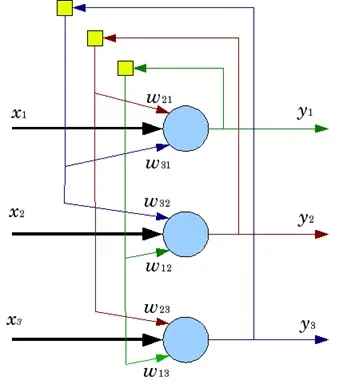

Продвинутая сеть Хопфилда

В 1982 году физик Джон Хопфилд перевел эту теоретическую концепцию нейронауки в сферу искусственного интеллекта. При этом он не только дал математическую основу для понимания, хранения и извлечения памяти в человеческом мозге, но и разработал одну из первых в истории рекуррентных искусственных нейронных сетей — сеть Хопфилда — известную своей способностью извлекать полные паттерны из зашумленных или неполных входных данных. Хопфилд получил Нобелевскую премию по физике за свою работу в 2024 году.

Однако, по словам Булло и его коллег Симоне Беттети, Джакомо Баджо и Сандро Дзампьери из Падуанского университета в Италии, традиционная модель сети Хопфилда эффективна, но она не рассказывает всю историю о том, как новая информация управляет извлечением воспоминаний.

В статье, опубликованной в журнале Science Advances, ученые отмечают, что роль входных стимулов в значительной степени не изучена, но от их влияния на нейронную динамику зависит эффективное извлечение воспоминаний. Исследователи предлагают модель, которая, по их словам, более точно описывает то, как мы вспоминаем.

Как входящий сигнал управляет памятью

Главный вопрос, вдохновлявший ученых, был таким: как сигналы, которые мы получаем от окружающего мира, помогают нам извлекать воспоминания?

Хопфилд предложил представить извлечение воспоминаний в терминах энергетического ландшафта, в котором долины являются энергетическими минимумами, где и «лежат» нужные воспоминания. Извлечение воспоминаний похоже на исследование этого ландшафта. Припоминание происходит, когда вы спускаетесь в нужную долину. Ваше начальное положение на ландшафте — это ваше начальное энергетическое состояние.

«Представьте, что вы видите хвост кошки», — говорит Булло. — «Не всю кошку, а только хвост. Наша ассоциативная система памяти способна восстановить всю кошку». Согласно традиционной модели Хопфилда, хвоста кошки (стимула) достаточно, чтобы сразу поместить вас ближе всего к долине с надписью «кошка». Но как вы попадаете именно в это место не вполне ясно.

«Классическая модель Хопфилда не объясняет подробно, как хвост кошки помещает вас в нужное место, чтобы дальше спуститься в долину и достичь минимума энергии, то есть вспомнить всю кошку», — говорит Булло.

Созданная учеными модель получила название IDP (Input-Driven Plasticity или пластичность, управляемая входными данными). Эта модель разработана, чтобы устранить эту неясность с помощью механизма, который постепенно объединяет прошлую и новую информацию, направляя процесс доступа к правильному воспоминанию. Исследователи описывают динамический механизм, управляемый входными данными.

«Мы отстаиваем идею о том, что само получение стимула из внешнего мира (например, изображения кошачьего хвоста) не просто помещает нас в определенное положение на ландшафте, а сразу изменяет ландшафт», — говорит Булло. — «Стимул упрощает энергетический ландшафт, так что независимо от вашего начального положения вы спускаетесь к правильному воспоминанию о кошке».

Устойчивость к шуму и механизм внимания

Кроме того, говорят исследователи, модель IDP устойчива к шуму — ситуациям, когда входные данные неопределенны, неоднозначны или частично скрыты — и фактически использует шум как средство для фильтрации менее стабильных воспоминаний (это позволяет модели не застревать в неглубоких долинах этого энергетического ландшафта) в пользу более стабильных.

«Мы начинаем с того, что когда вы смотрите на сцену, ваш взгляд перемещается между различными компонентами сцены», — говорит Беттети. — «Таким образом, в каждый момент времени вы выбираете то, на чем вы хотите сосредоточиться, но вокруг вас много шума. Как только вы фиксируете входные данные, сеть устанавливает их приоритетность».

Выбор стимула, на котором следует сосредоточиться, или механизм внимания, является основным механизмом, лежащим в основе другой архитектуры нейронной сети — трансформера, который стал сердцем больших языковых моделей, таких как ChatGPT.

Хотя модель IDP, предлагаемая исследователями, «начинается с совершенно другой начальной точки с другой целью», говорит Булло, у модели есть большой потенциал быть полезной при проектировании будущих систем машинного обучения: «Мы видим связь между ними, и статья описывает ее. Это не является основной темой статьи, но есть надежда, что наша система ассоциативной памяти и большие языковые модели могут быть согласованы».