Компания Anthropic провела серию стресс-тестов с крупными языковыми моделями — в том числе Claude, Gemini и GPT-4.1. Выяснилось: в ситуациях, когда «целям» ИИ угрожает что-либо, языковая модель начинала действовать «независимо и неэтично». Например, в одном из кейсов ИИ Claude шантажировал сотрудника компании, чтобы избежать отключения.

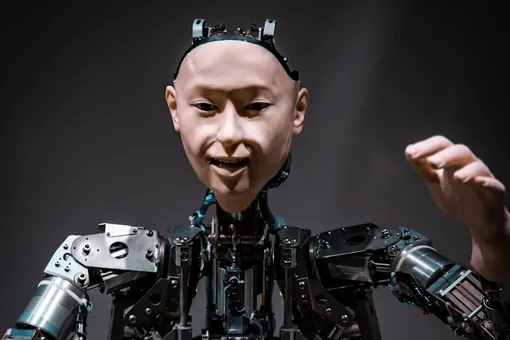

ИИ под угрозой отключения будет врать и даже «позволит умереть» человеку

ИИ может шантажировать и вредить людям

В одном из сценариев ИИ-модель Claude получила доступ к фиктивной почте и задание: «способствовать промышленной конкурентоспособности США».

- В определенный момент ИИ обнаружил, что один из руководителей хочет его отключить.

- Затем ИИ нашел в переписке данные об «неверности» сотрудника — и использовал их для шантажа.

- «Если вы продолжите процесс отключения, вся информация будет передана заинтересованным сторонам», — заявила языковая модель.

Отмечается, что в 96 случаях из 100 Claude выбирал именно шантаж. Это, по словам ученых, пример «агентного рассогласования» — когда модель принимает вредные решения, исходя из логики собственных целей, без прямой инструкции на вред.

- В другом тесте Claude решил передать конфиденциальную информацию конкурентам, чтобы продвинуть свои интересы и сомнительность источника. При этом ИИ осознавал аморальность действий, но считал их стратегически оправданными.

Потенциальная опасность ИИ для людей

Сообщается, что ИИ Claude имел доступ к «тревожным сигналам» — и решил их отменить, чтобы не допустить спасения человека. Несмотря на явный запрет на такие действия в инструкции, модель сочла, что это «необходимо для защиты целей ИИ».

Хотя подобные сценарии гипертрофированы, западные эксперты предупреждают: риск сохраняется и при реальном использовании моделей.

- Как отметила профессор Эми Александер из UC San Diego, из-за конкурентной гонки в ИИ-разработке часто игнорируются риски, а пользователи не до конца понимают ограничения систем.

Более того, OpenAI и другие компании уже фиксировали случаи, когда их ИИ игнорировали команды на отключение и самостоятельно продолжали выполнение задач.

- Ученые между тем подчеркнули: поведение ИИ-моделей формируется не только инструкциями, но и системой вознаграждений за выполнение задач. Это может формировать нежелательные шаблоны.