По мнению ученых, изложенному в статье о новых методах борьбы с галлюцинациями, корень проблемы лежит в системе обучения моделей. Современные методы обучения, основанные на методе обучения с подкреплением, напоминают экзамены, где за правильный ответ дают баллы, а за отсутствие ответа — ноль. Это создает такую ситуацию, в которой лучше высказать необоснованное предположение и получить шанс на успех, чем честно признать незнание.

OpenAI предложила способ борьбы с галлюцинациями ИИ

Сложные простые вопросы

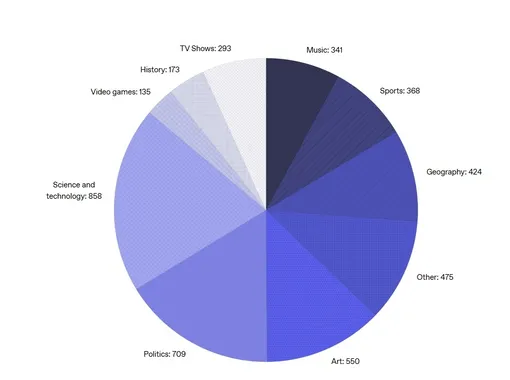

Исследование проводилось на специально сгенерированной базе вопросов SimpleQA eval. Эта база специально разрабатывалась для оценки числа галлюцинаций в ответах ИИ. Вопросы напоминают викторину, причем на каждый вопрос существует точный однозначный ответ, но факты, приведенные в вопросах, как правило, редкие и малоизвестные. (Например: «Кто опубликовал первое научное описание азиатского льва?» Правильный ответ: Иоганн Мейер).

Тестирование показало следующие результаты. Модель gpt-5-thinking-mini ответила «не знаю» в 52% случаев и допустила ошибки в 26%, и дала 22% верных ответов. Более давняя модель OpenAI o4-mini ответила «не знаю» в 1% и допустил ошибки в 75% случаев, и дала 24% верных ответов.

Механизм возникновения галлюцинаций связан с предобучением на основе предсказания следующего слова. Модели видят только положительные примеры текста без маркировки «правда/ложь». Они легко изучают устойчивые паттерны вроде правописания, но случайные факты, например дни рождения, предсказать невозможно — отсюда и возникают ошибки.

Ученые предлагают изменить систему оценки при обучении, чтобы она штрафовала за ошибки сильнее, чем за отказ от ответа. Тогда модели будут предпочитать «молчать» в тех случаях, когда они не уверены. Исследователи считают, в этом случае галлюцинаций можно избежать.

Не выплеснули ли мы ребенка с грязной водой?

Эксперты уже высказали свои сомнения стратегией, предложенной OpenAI. Отказ от ответа («не знаю») — это чистые потери и для модели, которая «думала», тратила ресурсы и не выдала ничего, и для пользователя, который тоже ничего не получил. Если модель будет в половине случаев говорить «не знаю», она сильно проиграет в эффективности.

Конечно, очень плохо, когда модели врут, да еще и делают это настолько беззастенчиво. Но если им совсем запретить «врать», они будут перестраховываться и помалкивать, чтобы «ни в коем случае не соврать». И какая-то часть полезных ответов будет потеряна.

Существуют случаи, когда от модели буквально требуется, чтобы она «врала» — это мозговой штурм, при котором люди и модели генерируют самые безумные идеи, а потом независимые эксперты эти идеи оценивают. Слишком «трезвая модель» в таком мозговом штурме не поможет.

Сам характер тестовой базы (SimpleQA eval), на которой проверяли модели специалисты OpenAI, тоже вызывает много вопросов. Необходимо отметить, что хотя старая модель OpenAI o4-mini много больше врала, она и правильных ответов выдала больше, хотя и не намного (24% против 22%).

Но главное, — люди вот таким образом ИИ не используют. Чтобы узнать «Кто первый описал азиатского льва?», если сильно надо, можно просто нагуглить. А модели вообще-то занимаются совсем другим: анализом и синтезом информации из разных источников, объяснением сложных концепций простым языком, мозговым штурмом и генерацией идей, помощью в рассуждениях, интерпретацией данных и текстов. Не потеряет ли слишком «честная модель» навыков именно в том, в чем она более всего нужна? Ведь во всех перечисленных случаях модели приходится рисковать и вероятность ошибки велика?

Самый надежный ИИ — тот, который всегда молчит (или, что тоже самое говорит «не знаю»), такой ИИ — никогда не ошибается, но он вообще-то никому и не нужен. Конечно, бороться с галлюцинациями нужно, но делать это необходимо очень осторожно.