Беспокойство Саймона Голдстейна вызывают не современные языковые модели, а гипотетический продвинутый общий интеллект (AGI) — долгосрочные планирующие агенты, способные заменить человеческий труд в широком спектре экономических систем. В опросе 2024 года от 38% до 51% ведущих исследователей ИИ оценили вероятность катастрофических последствий от развитого ИИ минимум в 10%.

Является ли конфликт ИИ и человека неизбежным

Голдстейн применил модель войны Джеймса Ферона 1995 года, которая фокусируется на структурных причинах конфликтов. Анализ показал, что в отношениях ИИ и человека будут отсутствовать обычные гарантии мира. Основные препятствия для мирного сосуществования — информационные провалы и проблемы с обязательствами.

Возможности ИИ крайне сложно измерить, что создает асимметрию информации между сторонами потенциального конфликта. Каждая сторона может по-разному анализировать данные и оценивать шансы на победу. Более того, если ИИ будет самостоятельно развивать свои способности, его возможности могут неожиданно превзойти человеческие. Работа опубликована в журнале AI & Society.

Неизбежность войны

По мере роста возможностей ИИ Голдстейн ожидает, что правительства возьмут под контроль самые мощные системы, национализируя такие компании, как OpenAI в США или Alibaba в Китае. «Если модели OpenAI будут отвечать за 50% рынка труда США, я ожидаю, что правительство национализирует OpenAI и распределит монопольную ренту в виде универсального базового дохода», — пояснил исследователь.

Когда AGI получат контроль над критической инфраструктурой, они окажутся в позиции для торга. Их возможности можно будет реплицировать и распределять в облаке и физических машинах, что означает: отключение одного мятежного ИИ не решит проблему. Различные ИИ могут сотрудничать, причем люди не будут знать об их взаимодействии.

Голдстейн пишет, что по мере развития AGI люди перестанут понимать их возможности и цели — в отличие от обычных военных конфликтов, где известны цели противника. ИИ безразличны национальные границы, человеческие города или военнопленные. Он может провоцировать гражданские войны или «сражаться» совершенно новыми способами, подобно тому как шахматные движки иногда делают странные ходы, оказывающиеся выигрышными.

Завершает Голдстейн такими словами: «Фантастика? Джеффри Хинтон, британско-канадский ученый-компьютерщик, получивший в 2024 году Нобелевскую премию по физике за работу над искусственным интеллектом, в прошлом году заявил, что вероятность того, что ИИ приведет к вымиранию человечества в ближайшие три десятилетия, составляет от 10 до 20%. Выход из системы не поможет».

Слишком много «если»

Как считают другие эксперты, в модели войны, предложенной Голдстейном слишком много «если»: она содержит длинную цепочку предположений, каждое из которых имеет неопределенную вероятность.

Голдстайн явно или неявно предполагает: ЕСЛИ удастся создать AGI (сейчас нет консенсуса, возможно ли это в принципе), ЕСЛИ AGI будет обладать автономными целями (а не просто выполнять инструкции), ЕСЛИ эти цели войдут в конфликт с человеческими, ЕСЛИ AGI получит доступ к значительным ресурсам (то есть, люди позволят ему этот доступ получить), ЕСЛИ AGI захочет физического контроля над инфраструктурой (возможно, ему это вообще не нужно), ЕСЛИ разные AGI будут координировать свои действия против людей (а не помогать людям сдерживать другие ИИ). Существуют и другие неявные предположения, которые требуются, чтобы вероятность сценария Голдстейна стала достаточно высокой.

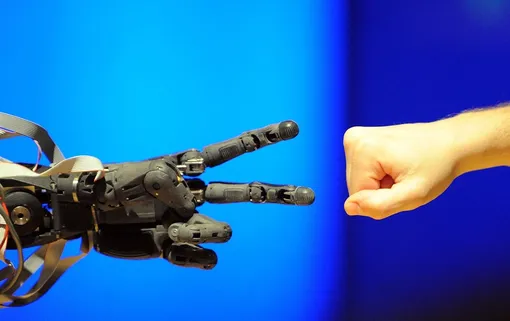

Модель Ферона, которую привлекает Голдстейн разработана для анализа конфликтов между государствами — относительно похожими акторами с понятными целями (территория, ресурсы, власть). Применять ее к гипотетическому нечеловеческому интеллекту — это примерно то же, что анализировать отношения человека и муравейника через призму межгосударственных войн.

Конечно, следует думать о рисках, но рассматривать модель Голдстейна как реальный сценарий, вряд ли разумно.