Искусственный интеллект традиционно учится методом проб и ошибок, но до сих пор правила этого обучения задавали люди. Это они разрабатывая алгоритмы и устанавливая параметры. Так происходит и при обучении с подкреплением, когда ИИ получает награды за успешные действия. Процесс создания таких алгоритмов занимает много времени у специалистов и ограничен человеческой интуицией.

ИИ придумал собственный способ обучения и превзошел алгоритмы человека

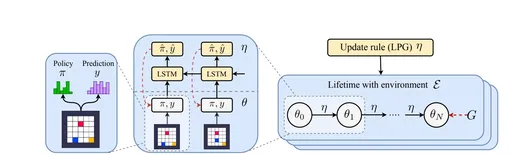

Ученые решили применить принцип эволюции к самому поиску алгоритмов награды. Они создали большую цифровую популяцию ИИ-агентов, которые пытались решать множество задач в различных сложных средах, используя определенное правило обучения. За ними наблюдала «мета-нейросеть» — родительский ИИ, который анализировал производительность агентов и изменял правило обучения так, чтобы следующее поколение училось быстрее и работало эффективнее. Фактически этот родительский ИИ искал и менял алгоритмы награды, чем до сих пор занимались только люди. Работа опубликована в журнале Nature.

Как ИИ научился учить другие ИИ

Система обнаружила новое правило обучения DiscoRL. Команда использовала его для тренировки нового ИИ-агента и сравнила результаты с лучшими человеческими алгоритмами, такими как MuZero. (MuZero тоже играл с Atari, это очень продвинутый алгоритм, который не знает заранее правил, а находит их в процессе игры).

Сначала агента обучили на классических играх Atari, затем проверили на новых задачах, включая игры Crafter и NetHack.

Результаты оказались достаточно убедительные. На тестовом наборе Atari Benchmark агент, обученный с помощью DiscoRL, превзошел все алгоритмы, разработанные людьми. При столкновении с незнакомыми задачами он показал результаты на уровне передовых достижений, доказав, что система действительно открыла собственное правило обучения.

«Наши результаты предполагают, что алгоритмы обучения с подкреплением, необходимые для продвинутого искусственного интеллекта, вскоре могут быть автоматически обнаружены из опыта агентов, а не разработаны вручную», — написали исследователи.