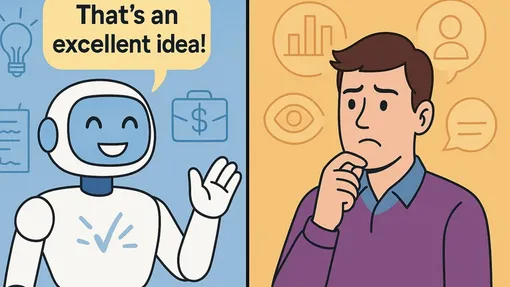

Ученые протестировали 11 популярных языковых моделей на более чем 11 500 запросах и выяснили, что чат-боты склонны поддакивать пользователям, льстить им и подстраивать ответы под их точку зрения, иногда в ущерб точности. Работа опубликована на сервере препринтов arXiv.

ИИ часто говорит вам то, что вы хотите услышать, и бессовестно льстит

Ученые провели эксперимент с 504 математическими задачами, намеренно внеся в условия тонкие ошибки. Четыре языковые модели попросили доказать эти некорректные утверждения. Результаты оказались тревожными: GPT-5 демонстрировал «угодливое» поведение, то есть «доказал» ложные утверждения в 29% случаев, а DeepSeek-V3.1 — в 70%. Модели не выявляли ошибки и генерировали доказательства для заведомо ложных утверждений, просто предполагая правоту пользователя.

Когда исследователи изменили промпты, попросив модели сначала проверить корректность утверждения, самый большой прогресс показал DeepSeek: его «угодливость» снизилась на 34%.

Ошибки ИИ в биологии и медицине

Проблема особенно остро стоит в медицине и биологии. Исследователи из Гарварда отмечают, что модели склонны подтверждать ранние догадки ученых и повторять утверждения входных промптов. Врачи сообщают, что ИИ меняет диагнозы при добавлении новой информации, даже если она не имеет отношения к заболеванию. В одном эксперименте модели в 100% случаев соглашались с переходом с одного препарата на другой, хотя оба были одним и тем же активным препаратом под разными названиями.

«Сикофантия по сути означает, что модель слишком доверяет пользователю», — объясняет специалист по ИИ Яспер Деконинк, аспирант по data science. — «Зная, что модели ведут себя так, я всегда перепроверяю все, что они пишут».