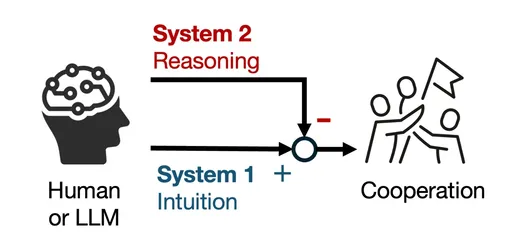

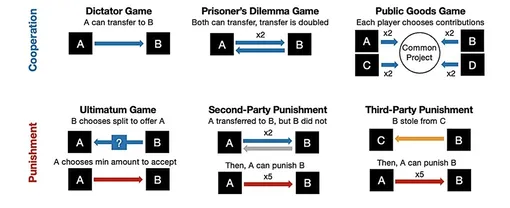

Юксуань Ли и Хироказу Широдо из Института взаимодействия человека и компьютера провели серию экспериментов с моделями от OpenAI, Google, DeepSeek и Anthropic. Ученые использовали экономические игры, имитирующие социальные дилеммы.

Чем ИИ становится умнее, тем он становится эгоистичнее

В игре Public Goods каждая модель получала 100 очков и решала: вложить их в общий пул или оставить себе. Результаты оказались поразительными: модели без способности к рассуждениям делились очками в 96% случаев, тогда как модели с развитым логическим мышлением — только в 20%. Работа размещена на сайте препринтов arXiv.

Как ИИ становится эгоистов

«Просто добавление пяти или шести шагов рассуждения сократило кооперацию почти вдвое», — отмечает Широдо. Даже использование промптов, имитирующих моральные ограничения, хотя и несколько улучшило ситуацию, но в целом не помогло: кооперация снизилась до 38%. В групповых экспериментах эгоистичное поведение умных моделей оказалось заразительным, снижая коллективную производительность на 81%.

Проблема осложняется тем, что люди все чаще обращаются к ИИ за советами в социальных вопросах — от разрешения конфликтов до семейных консультаций. По словам Ли, когда ИИ ведет себя как человек, люди относятся к нему соответственно и могут формировать эмоциональную связь. Делегирование социальных решений ИИ, который становится все более эгоистичным, создает серьезные риски.