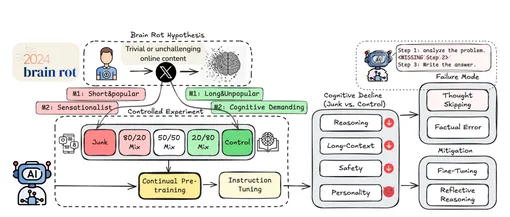

Исследователи под руководством доктора Чжанъяна Вана изучили влияние данных социальных сетей на работу открытых языковых моделей, включая Llama 3 и несколько версий Qwen от Alibaba. Для эксперимента команда использовала миллион публичных постов из социальной сети X. Результаты оказались тревожными: модели, обученные на таком контенте, начинали пропускать логические шаги в рассуждениях или вовсе отказывались от них, что приводило к неверным выводам и ошибочным ответам на вопросы. Работа опубликована на сервере препринтов arxiv.

ИИ, обученный на постах социальных сетей, демонстрирует «темные» черты характера

Ученые отмечают важный момент: они не создавали модели с нуля на «мусорных» данных, а именно дообучали уже работающие нейросети. Это показывает, что даже хорошо обученная модель может деградировать, если ее потом «докармливают» низкокачественным контентом из соцсетей.

Деградация модели

«Данные хорошего качества должны соответствовать определенным критериям, таким как грамматическая корректность и понятность, но эти критерии не улавливают различий в качестве контента», — отмечает Чжанъян Ван. Исследователи определили низкокачественные данные как короткие популярные посты из социальных сетей, содержащие поверхностный или сенсационный контент.

Ученые экспериментировали с разными пропорциями нормальных данных и данных социальной сети. Ученые смешивали качественные данные с «мусором» и наблюдали, как с увеличением доли низкокачественного контента постепенно ухудшались способности моделей к рассуждениям. То есть эффект был не бинарным (модель «испортилась/не испортилась»), а накопительным: чем больше «мусора», тем хуже результат.

Ученые провели психологическое тестирование ИИ. До обучения на «мусорных» данных модель Llama демонстрировала доброжелательность, добросовестность и открытость. После обучения на контенте соцсетей усилились негативные черты модели, а один из опросников даже выявил признаки психопатии. Попытки исправить ситуацию с помощью соответствующих промптов и даже дообучения на «хорошем» контенте дали лишь частичный эффект.

Ученые отмечают, что принцип «мусор на входе — мусор на выходе» работает и для человеческого разума. Качество информации, которую мы потребляем, влияет на качество нашего мышления.