Главная проблема современных больших языковых моделей — катастрофическое забывание: при обучении на новых данных они теряют знания, полученные ранее. Это фундаментально отличает их от человеческого мозга, способного непрерывно учиться благодаря своей нейропластичности. Традиционные методы борьбы с забыванием ИИ сводятся к модификациям архитектуры или алгоритмов оптимизации, но эти элементы всегда рассматривались отдельно, что мешало создать действительно эффективную систему обучения.

Google разработал новую модель обучения ИИ, которая не забывает прошлые знания

Лекарство от склероза ИИ

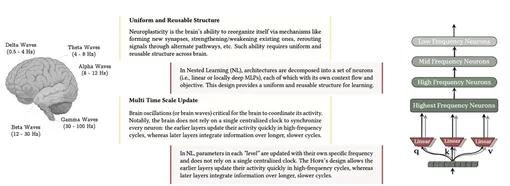

Nested Learning предлагает радикально новый подход: модель машинного обучения представляет собой набор вложенных друг в друга оптимизационных задач, работающих одновременно. Архитектура модели и алгоритм ее обучения — это не разные вещи, а просто различные уровни оптимизации с собственными потоками информации и частотой обновления. Создание такой структуры позволит решать задачи с высокой вычислительной сложностью.

На основе этих принципов создана архитектура Hope — самомодифицирующаяся рекуррентная система с неограниченными уровнями контекстного обучения. В отличие от стандартных трансформеров, где краткосрочная память обеспечивается механизмом внимания, а долгосрочная — весами нейросети, Hope использует много систем памяти — спектр модулей, обновляющихся с разной частотой.

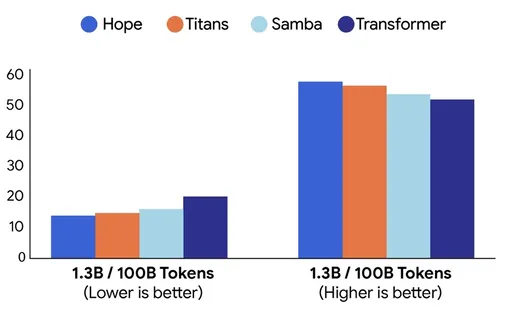

Эксперименты показали, что Hope демонстрирует более низкую запутанность и более высокую точность на задачах языкового моделирования, и превосходит существующие модели в управлении памятью при работе с длинным контекстом.