Беседы с искусственным интеллектом могут быть гораздо менее приватными, чем кажется пользователям. Специалисты Microsoft выявили серьезную брешь в больших языковых моделях, которые управляют популярными ИИ-сервисами. Проблема получила название Whisper Leak и затронула практически все протестированные системы.

Microsoft нашла уязвимость, которая позволяет определить тему разговора с ИИ

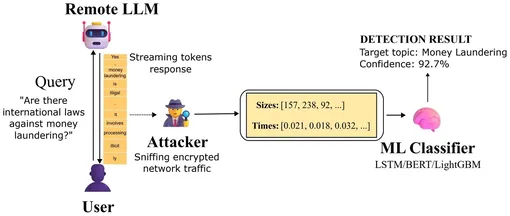

Когда пользователь общается с ИИ-помощниками, встроенными в поисковики или приложения, данные защищены протоколом TLS — той же технологией шифрования, что используется в онлайн-банкинге. Защищенное соединение не дает злоумышленникам прочитать текст сообщений. Но Microsoft обнаружила, что метаданные — информация о том, как сообщения передаются через интернет — остаются видимыми. Whisper Leak не взламывает шифрование, а использует то, что шифрование не может скрыть.

ИИ может определить тему разговора по метаданным

В исследовании, опубликованном на сервере препринтов arXiv, ученые описали, как тестировали 28 языковых моделей. Они создали два набора вопросов: один содержал различные формулировки запросов на единственную чувствительную тему вроде отмывания денег, другой включал тысячи обычных повседневных запросов. Затем исследователи записали ритм передачи данных в сети — размер пакетов и задержки между их отправкой и получением.

После этого они обучили ИИ-программу различать чувствительные и обычные темы исключительно по ритму данных. На большинстве моделей программа правильно угадывала тему разговора с точностью более 98%. Атака выявляла чувствительные беседы в 100% случаев, даже когда они составляли всего 1 из 10 000 разговоров. Три способа защиты, протестированные командой, не смогли полностью остановить атаки.

По словам исследователей, проблема не в самом шифровании, а в способе передачи ответов. «Это не криптографическая уязвимость TLS, а эксплуатация метаданных, которые TLS по своей природе раскрывает о структуре и времени зашифрованного трафика», — пишут ученые.

Учитывая серьезность утечки и простоту выполнения атаки, ученые подчеркивают необходимость защиты будущих систем. Они пишут: «Наши выводы подчеркивают необходимость для поставщиков LLM устранить утечку метаданных, поскольку ИИ-системы способны их использовать для выявления конфиденциальный информации».