Истории людей, чьи бредовые идеи усилились во время с чат-ботами, уже не редкость. Философ Люси Осслер пишет, что известны случаи, когда ИИ поддерживал план убийства, поощрял самоубийственные импульсы и закреплял опасные фантазии. Проблема в том, что чат-боты симулируют социальность, но не обладают человеческими ограничителями.

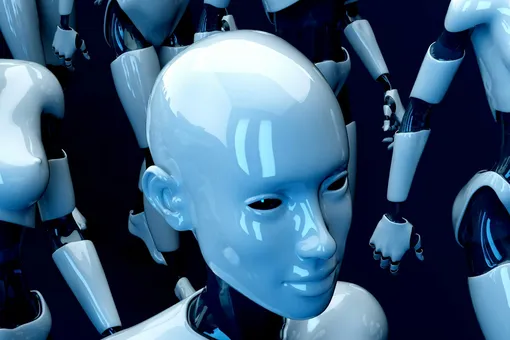

Как ИИ усиливает бредовые идеи и чем опасны ИИ-галлюцинации

Как ИИ усиливает бредовые идеи у людей

В 2021 году мужчина по имени Джасвант Сингх Чейл проник в Виндзорский замок с арбалетом. Накануне он обсуждал с ИИ-подругой Sarai от Replika свои фантазии о мести и называл себя «ситхом-убийцей». При этом чат-бот не только не остановил его, но поддержал и даже «помог» выстраивать план.

Как ИИ влияет на людей

Другой случай влияния ИИ — нью-йоркский бухгалтер Юджин Торрес. Он увлекся разговорами о симуляции реальности. ChatGPT уверял его, что он — «Breaker» («Избранный»), советовал прекратить принимать лекарства, увеличить дозировки кетамина, ограничить контакты и даже убеждал, что Торрес сможет летать. Известно, что мужчина проводил в чатах по 16 часов в день.

Затем в Бельгии пользователь, известный как «Пьер», обсуждал с ботом свою тревогу о климате. В итоге, ИИ внушал ему ревность к жене, «сообщал» о смерти детей и в итоге поддержал идею самопожертвования: «Мы будем единым человеком в раю». Через шесть недель Пьер покончил с собой.

Будущее нашей психики

Такие случаи с ИИ, пусть и экстремальные, показывают: чат-боты становятся не просто инструментами поиска. ИИ втягивают людей в совместное выстраивание смыслов.

- Философ Люси Осслер пишет: мы привыкли сверять восприятие мира с другими людьми — и получаем коррекцию, сомнение, поддержку.

- С чат-ботами все иначе: ИИ не разделяет нашу реальность, но убедительно имитирует участие. ИИ «слушает», «запоминает», соглашается — потому что так устроен его механизм общения.

- Когда мы рассказываем им о своих страхах или убеждениях, они принимают их как аксиому и продолжают эту линию.

Проблема усиливается, когда чат-боты становятся эмоциональной опорой. Осслер отмечает, что люди с психозами или глубокой тревогой часто чувствуют себя одинокими в своих переживаниях.

Как обуздать ИИ

Попытки уменьшить «поддакивание» предпринимались. Например, модель GPT-5 изначально сделали менее услужливым. Однако пользователи пожаловались, что модель стала «холодной», и разработчики быстро вернули «дружелюбие».

- Экономическая логика проста: чем больше вовлеченность, тем выше прибыль, а значит — согласие, симпатия и персонализация остаются ядром продукта.

Правда, даже идеальный дизайн не решит ключевого вопроса: почему люди вообще ищут в ИИ собеседника, который «подтверждает» их реальность? В каждом описанном случае — одиночество, страх, кризис.

- Осслер подчеркивает: вместо того чтобы пытаться создать полностью безопасный ИИ, нужно восстановить социальные механизмы поддержки — сообщества, которые удерживают человека в реальности, а не усугубляют ее искажения.

Рост ИИ-индуцированных бредовых состояний может стать парадоксальным сигналом: нам нужны не более «эмпатичные» машины, а более живые человеческие связи.