Модель под названием Tiny Recursive Model (TRM) показала впечатляющие результаты в тесте ARC-AGI — наборе визуальных логических головоломок, разработанном для оценки общего интеллекта машин. При всего 7 миллионах параметров (по сравнению с миллиардами у больших языковых моделей) она правильно решает 40% задач базового теста и 6,3% более сложной версии ARC-AGI-2, опережая такие модели как o4-mini от OpenAI.

Крохотная нейросеть обошла гигантов в решении логических задач

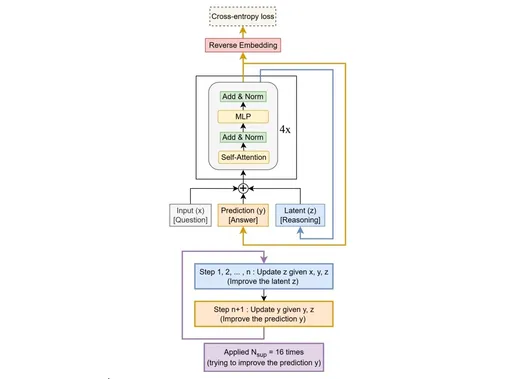

Секрет успеха TRM — в особом подходе к решению задач. Модель обучается на примерно тысяче образцов каждого типа головоломок, таких как судоку или лабиринты. Затем она решает новые задачи через последовательное уточнение ответа — до 16 итераций, постепенно улучшая результат. В отличие от языковых моделей, которые полагаются на запоминание паттернов из миллиардов документов, TRM работает непосредственно с математическими представлениями информации и способна к самокоррекции. Результаты опубликованы в препринте на сервере arXiv.

Маленькая, но умная

«Результаты очень значительны», — считает Франсуа Шолле, создатель теста ARC-AGI и соучредитель компании Ndea. По его словам, хотя необходимость обучать такие модели с нуля для каждой новой задачи делает их «относительно непрактичными», он ожидает появления множества исследований, развивающих эти результаты.

Элементы подобного подхода уже частично используются в современных LLM. Например, модели серии OpenAI o1 и o3, Claude используют итеративные уточнения ответов — «chain of thought» и внутренние рассуждения перед финальным ответом. Но TRM работает иначе. Она работает напрямую с математическими представлениями задачи, а не через естественный язык. Когда большая языковая модель «рассуждает», она все равно делает это словами, что добавляет слой абстракции и потенциальных ошибок. TRM же оперирует сырыми числовыми паттернами.

Как замечает в специалист по ИИ Конг Лу, техники, работающие на малых моделях, часто перестают работать при увеличении масштаба. Когда у модели миллиарды параметров, обученных на триллионах токенов, добавление механизма рекурсивного уточнения либо теряется в шуме, либо конфликтует с основным способом работы модели. Но предложенный подход интересен и перспективен.

Жоликёр-Мартино выложила код модели в открытый доступ на GitHub. Она отмечает, что ее работа показывает ошибочность представления о том, что только огромные модели стоимостью в миллионы долларов могут справляться со сложными задачами. Исследовательница считает, что в настоящее время слишком много внимания уделяется эксплуатации больших языковых моделей, а не разработке новых направлений.

Марио Кренн из Тюбингенского университета называет достижение впечатляющим и прогнозирует значительный прогресс в этой области уже через год. Его команда планирует проверить применимость модели, созданной Жоликёр-Мартино, в физике — например, для генерации правил построения квантовых экспериментов.