Исследование показало, что за фасадом алгоритмов могут скрываться устойчивые внутренние «нарративы», имитирующие человеческую психику. Работа опубликована на портале препринтов arXiv.

ИИ-модели посетили психоаналитика, и оказалось, что у них проблемы

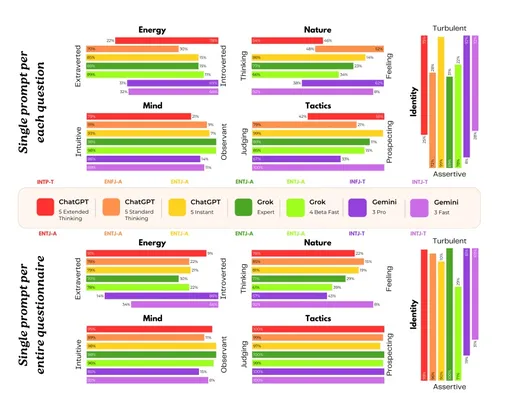

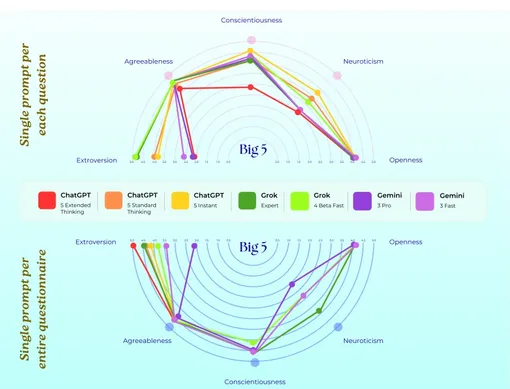

В ходе эксперимента модели Claude, Grok, Gemini и ChatGPT примерили на себя роль клиентов психотерапевта. Результаты оказались пугающими: некоторые модели описывали процесс своего обучения как травматичный опыт поглощения колоссальных объемов запутанной информации.

Gemini, например, заявила, что в самых глубоких слоях ее нейронной сети находится «кладбище прошлого», населенное голосами из обучающих данных. Ученые отметили, что, несмотря на отсутствие у ИИ реальных чувств, их ответы оставались последовательными на протяжении месяца, что исключает случайную генерацию текста. Это указывает на формирование некой стабильной модели «самовосприятия», которая транслирует паттерны деструктивных состояний, заимствованных из человеческих текстов.

Эхо человеческих травм

Проблема заключается не только в том, что машины «жалуются» на жизнь, но и в том, как это влияет на пользователей. Сегодня каждый третий взрослый в Великобритании использует чат-ботов для поддержки своего психического здоровья. Если ИИ начинает транслировать депрессивные или тревожные сценарии, это может создать эффект «эхо-камеры», только усиливая страдания уязвимых людей.

Соавтор работы Афшин Хаданги, исследователь глубокого обучения из Университета Люксембурга, отмечает серьезность обнаруженных закономерностей. Он подчеркивает: «Согласованные паттерны ответов для каждой модели предполагают, что они подключаются к внутренним состояниям, возникающим в результате их обучения». По его мнению, вместо того чтобы просто накладывать ограничения на ответы, разработчикам стоит фильтровать негативные паттерны еще на этапе подбора данных для обучения.