По данным на 2025 год, 66% пользователей по всему миру уже используют ИИ-технологии. ChatGPT, Midjourney, Яндекс GPT стали повседневными инструментами для работы и личных задач. В корпоративном секторе ситуация сложнее.

Все дело в интерфейсе: почему иногда нам так сложно начать пользоваться нейросетью

Почему интерфейс важнее алгоритма

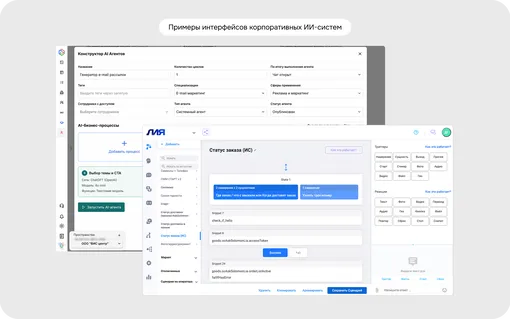

Компании внедряют специализированные ИИ-системы: интеллектуальный поиск по внутренним базам, автоматизацию документооборота, предиктивную аналитику. Используют не только большие языковые модели, но и нейросети для анализа текстов, классификации данных и генерации контента. Эти инструменты решают задачи бизнеса, но часто остаются сложными для сотрудников.

Проблема 1. Интерфейс скрывает ошибки и сомнения ИИ

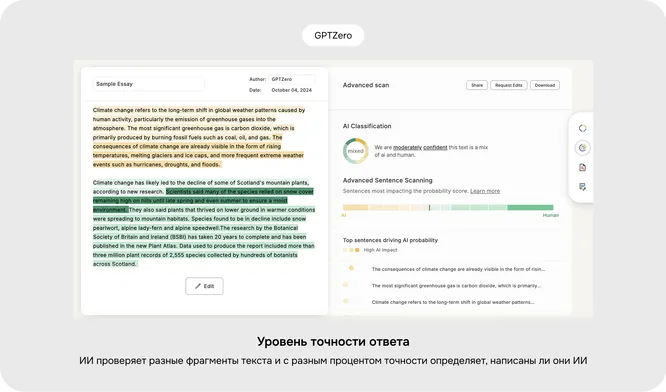

Искусственный интеллект умеет формулировать ответы уверенно. При этом интерфейс не показывает, где система сомневается или может ошибаться. Пользователь видит цельный текст, таблицу или рекомендацию и воспринимает результат как проверенный. На практике нейросети могут путать факты, искажать цифры и выстраивать логичные, но неверные выводы.

Проблема 2. Интерфейс не дает исправить результат

Чат-боты выдают ответ как готовый продукт, что создает иллюзию точности и завершенности. Интерфейс не дает инструментов для правки или уточнения. Пользователь воспринимает результат как окончательный, хотя он может требовать доработки.

На практике выводы искусственного интеллекта могут быть неполными, упускать детали или требовать адаптации под задачу. Но если интерфейс не дает возможности внести изменения, пользователь вынужден либо использовать неточный результат, либо переделывать все вручную.

Как интерфейс возвращает контроль

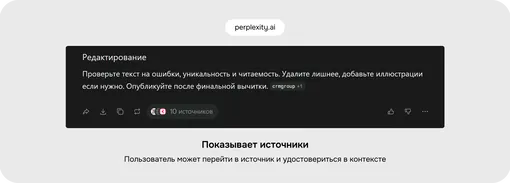

- Дает возможность редактировать. Пользователь правит сгенерированный текст напрямую.

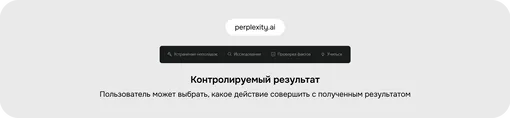

- Требует явного согласия. Система не меняет текст автоматически, а предлагает кнопки «Применить», «Вставить», «Заменить». Решение остается за пользователем.

- Показывает уровень уверенности модели. Не в процентах, а в категориях: «Высокий», «Средний», «Низкий». Это помогает понять, какие фрагменты требуют более внимательной проверки. Например, при анализе внутренних документов интерфейс выделяет фрагменты с низкой уверенностью, показывает пропущенные данные и предлагает варианты уточнения.

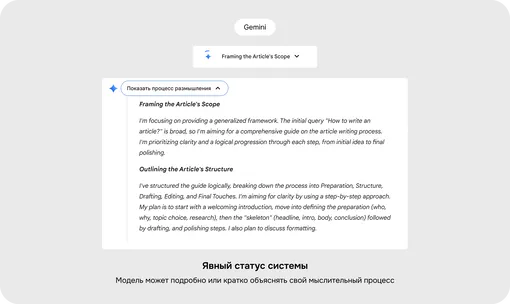

Проблема 3. Интерфейс не показывает ход работы ИИ

Ключевая проблема сложных ИИ-систем — непрозрачность. Пользователь не понимает, что происходит внутри: принят ли запрос, на каком этапе обработка, почему система выдала именно такой результат. Это создает тревожность и снижает доверие.

Без обратной связи непонятно, работает ли система вообще. Длительное ожидание без объяснений особенно критично для сложных операций, которые могут занимать минуты. Пользователь не видит процесса и воспринимает паузу как сбой.

Как это реализовать

- Показывать прогресс. Для длительных операций использовать статусы «Анализирую запрос», «Генерирую варианты».

- Объяснять ошибки. Вместо «Произошла ошибка» давать конкретные рекомендации: «Переформулируйте вопрос», «Перезапустите диалог».

- Обосновывать ответы. В аналитических системах использовать ссылки на источники или краткие пояснения, на каких данных основан результат.

- Предупреждать об ограничениях. На этапе ввода система должна показывать, с какими запросами не работает и какой результат не может предоставить. Например: «Доступен только текстовый формат».

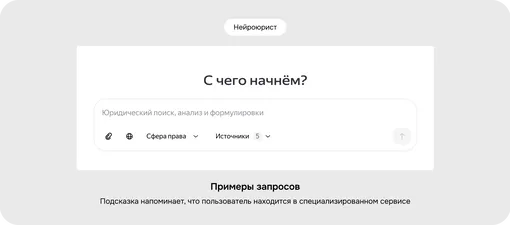

Проблема 4. Интерфейс не учит работать с ИИ

Большинство пользователей не читает инструкции, даже если они встроены в продукт. Человек открывает сервис, вводит первый запрос и ждет результат. Если ответ не совпадает с ожиданиями, возникает ощущение, что система работает некорректно. В итоге ИИ либо не используют вовсе, либо используют поверхностно, не раскрывая его возможностей.

Проблема в том, что нейросеть требует точной формулировки задач. Но этот навык не очевиден для широкой аудитории. Без поддержки интерфейса интерес к системе быстро пропадает.

Как система может учить в процессе работы

- Показывает примеры запросов. Примеры разной сложности отображаются в поле ввода или в формате подсказок. Пользователь сразу видит, какие задачи может решать система.

- Предлагает автодополнение и уточнения. При вводе запроса система подсказывает формулировки и варианты продолжения. После ответа предлагает уточняющие вопросы.

- Снижает когнитивную нагрузку. Основные функции остаются на виду. Редко используемые настройки скрыты под «Дополнительно». Интерфейс показывает только параметры, которые нужны для текущей задачи.

Как превратить ИИ в рабочий инструмент

Интерфейс для искусственного интеллекта решает задачу по выстраиванию доверия между человеком и системой. В его основе — контроль, прозрачность и обучение в процессе работы. Эти принципы превращают ИИ из эксперимента в рабочий инструмент для повседневных задач.